科普:GPT 是如何工作的?

到目前为止,您可能已经听说过 OpenAI 的 ChatGPT,或者其他替代品 GPT-3、GPT-4、微软的 Bing Chat、Facebook 的 LLaMa 甚至谷歌的 Bard。它们是可以参与对话的人工智能程序。令人印象深刻的聪明,它们很容易被误认为是人类,并且擅长执行各种任务,从撰写论文到创建网站。

计算机如何进行这样的对话呢?让我们看看它是如何工作的。

概率方法

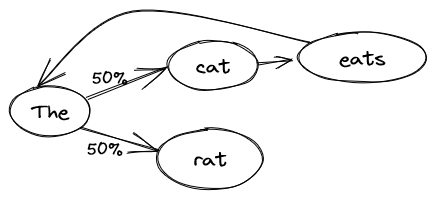

自然语言的最简单模型是朴素概率模型,也称为马尔可夫链 。这个想法很简单:取一个参考文本,越长越好,学习单词序列的概率。例如,给定一个句子:

猫吃老鼠。

该模型将学习在“猫”之后总是有“吃”,然后是“老鼠”。但在“老鼠”之后,有 50% 的概率出现“猫”,50% 的概率出现“老鼠”。我们可以使用这个模型来询问在一个不完整的句子之后的下一个单词是什么。如果我们重复这个过程,我们可以生成整个句子。

如果我们让模型生成一个句子,我们可能得到与训练文本完全相同的内容:

猫吃老鼠。

我们也可能得到:

老鼠。

猫吃猫吃猫吃老鼠。

每次我们遇到“老鼠”这个词时,模型都可以在“老鼠”或“猫”之间进行选择。

当然,我们用来训练模型的文本会长得多,但您已经可以看到其中的一些问题。如果我们在整个维基百科网站上进行训练,我们可能会得到类似这样的内容:

解释他的行为,并因为戴维斯强烈的语言和文化而被送进精神病医院。

这个句子更复杂,词汇更丰富,但它没有任何意义,因为模型缺乏上下文:它只是用最新的单词来生成下一个单词。我们可以扩展模型来考虑2、3或4个上下文词(“吃的”后面是“老鼠”),但那样我们可能只是重复输入文本的整个部分:在维基百科上有多少次恰好是4个词的相同序列?

从单词到意义

到目前为止,其中一个问题是我们将单词视为一堆没有意义的字母。该模型不能理解“the”和“a”之间、 “king”和“queen”之间等的关系。我们如何从单词中提取意义呢?试图向计算机解释含义并定义单词是一个死胡同,任务太复杂了(人们已经尝试了几十年)。您甚至如何表示一个单词的意义?好吧,有一件事计算机能完美理解:数字。如果我们沿着几个轴用数字表示单词的意义会怎么样?

例如:在-1(阳性)到1(阴性)的范围内,您如何评价这个词?

国王:-1 女王:1 桌子:0 胡子:-0.9

或者:在-1(刻薄)到1(友好)的范围内,您如何评价这个词?

狼:-0.8 公主:0.9 桌子:0.1 礼物:1

甚至:在-1(名词)到1(动词)的范围内,您如何评价这个词?

国王:-1 说话:1 漂亮:0

等等。通过足够的轴来评估单词,我们应该能够得到一个单词意义的近似值。问题变成:如何选择轴,如何评估所有单词?再次,任务如此复杂,我们让计算机完成繁重的工作:我们只告诉它出现在一起的单词具有相关的含义。有了足够的文本,计算机可以确定轴及其评估。在我们的猫例子中,猫和老鼠都是动物(接近的含义),而知道“吃”是动物做的事情是有用的。但在一本数学教科书中,将不会有猫或老鼠,因为它们的意义与教科书中使用的词汇相去甚远。

我们得到的轴线通常很难解释:我们可能会发现一些预期的轴线,如阳性/阴性,但大多数将更加复杂,要么在与其他轴线结合时才有意义,要么一次代表多个概念。

这种方法被称为“词嵌入”,将单词表示为一系列数字的向量。

从意义到关系

现在我们已经将意义转化为数字,我们可以利用一些有趣的属性:例如,我们可以将它们相加。这意味着什么呢?例如,将“美国”和“货币”相加(或者说,将它们的数字表示相加)将得到“美元”(或者说,与“美元”的数字表示相近的数字)。 “美国”+“首都”=“华盛顿”,“吃”+“名词”=“餐”,等等。

我们也可以相减:例如,“国王”-“男人”+“女人”=“女王”,或者“华盛顿”-“美国”+“英国”=“伦敦”。

我们还可以用它来找到密切相关的单词,同义词。

我们可以学习这些关系吗?

通过使用这种数字化单词表示,我们可以回到最初的模型,但这次学习关系而不是单词。然而,由于关系更复杂,我们需要更多的上下文。幸运的是,既然我们有了数字,我们就可以使用近似值。与其学习“在“猫”之后,有“吃””,我们可以学习像这样的关系:“在冠词和名词之后,通常有动词”,“动物经常吃、喝和跑”,“老鼠比猫小”,以及“你只能吃比你小的东西”。当然,一切都是用数字表示的。

这些关系是复杂的,所以我们需要大量的文本来训练模型。它们以方程式表示:想象 y=ax1 + bx2 + c,但输入(不同的 x1)和参数(a、b 和 c)更多。现在,模型不再是从一个单词到另一个单词的概率,而是每个轴(如男性/女性)都有一个方程式。总的来说,模型有数千亿甚至数万亿的参数!这使得它能够考虑到更大的上下文:

- 20个单词可以让它构建一个具有正确结构的简单句子。

- 100个单词可以让它在一个小段落里发展一个简单的想法。

- 有了一千个单词,它就可以在不失踪的情况下进行对话。

- 最大的模型有大约20000个单词,这使得它们在生成下一个单词之前,仍然可以考虑整个上下文,阅读整篇文章,一个短篇故事,或进行一次长对话。

最后,一切都是规模问题:一个更大的模型可以学习更多的关系,并考虑更多的上下文。

GPT的优势和劣势是什么?

GPT擅长生成看起来像是人类所写的文本。它能够逻辑地连接思想,捍卫它们,适应上下文,进行角色扮演,并且(特别是最新的GPT-4)避免自相矛盾。

不幸的是,它可能会说谎,或者在缺乏数据的情况下让自己的想象力发挥得淋漓尽致。要求解一个数学问题的结果,有可能得到一个近似甚至完全错误的答案。鉴于训练数据截至2021年9月,它在被问及当前事务时会捏造事实。为了避免这种情况,Bing Chat和Google Bard将模型连接到搜索引擎(Bing或Google),以便让它请求最新的信息。

为了有效地利用GPT,关键是将其应用于要么模糊且容错率高的任务(生成营销电子邮件?),要么易于验证的任务,无论是通过(非AI!)程序还是由人工参与的环节。

模型能思考吗?

现在我们知道了它是如何工作的,第一个答案是不能:该模型只是一个生成下一个单词概率的高级数学方程式。

然而,值得考虑的是我们自己的大脑:我们有一张由神经元(1000亿)组成的网络,每个神经元相互连接(每个神经元有1万个连接),对上下文做出反应,从经验中学习,并产生合适的(但往往难以精确预测)答案。换句话说,除了我们的算法是化学的而不是数字的之外,结构是相似的。

那么差异在哪里?

- 复杂性相差3个数量级:人类大脑比GPT-4的参数多1000倍的连接。因此,它可以处理更复杂的情况。

- 持续学习:大脑不断学习,包括在对话过程中,而GPT在对话开始之前就已经完成了训练。

- 仅限于文字:GPT界面仅限于文字。然而,正如我们所看到的,内部有一个语义系统,仅在最后一步才转换回文字。可以想象训练这样一个模型来控制机器人(只要有足够的训练数据)。

- 输入受限:GPT了解对话的唯一信息是文本。人类交流中多达60%的信息是非言语的:语调,声音节奏,面部表情,甚至一些潜意识的因素(如气味)都在起作用。GPT无法感知所有这些信息。

我们还可以提到其他一些行为层面的差异:

- GPT在始终应用逻辑规则方面存在困难,它更像是尽力而为的情景。具有讽刺意味的是,它不懈如何做数学。但这可以与一个小孩子进行比较。

- GPT没有情感:人类情感涉及许多腺体和激素,它们与大脑有复杂的相互作用。然而,GPT从人类之间的对话中学到了与情感状态相关的行为。如果它能表现得像有情感一样,这是否有意义?有些对话记录显示,GPT表现得像它意识到自己是一个程序,并有时会问一些存在主义问题。

- 你可能会认为GPT没有意识。意识的定义经常发生变化,取决于个人,但通常以这样一种方式定义,即只有人类才符合意识的标准。如果一个程序的行为与人类无法区分,我们是否会认为它有意识?中国房间论证3持相反观点:如果通过遵循指示而不了解中文本身就可以被视为会说中文的人,那么仅仅“遵循程序”的计算机就不了解中文,从而扩展到没有意识。

对社会的影响是什么?

我无法预测未来,尤其是在一项革命性技术的开始阶段,但我知道这是一项革命性的技术。对于许多知识工作者,从市场营销到工程师,从招聘人员到社会工作者,GPT将会改变许多事物。就像装配线改变了手工艺人的工作,计算器和计算机改变了会计,大众媒体改变了政治一样,GPT将改变知识工作者的世界。

当然,所有这些工作不会在一夜之间消失:我们仍然需要手工艺人和会计师,但在你的市场部门曾经需要10个人的团队的地方,也许一两个配备了GPT的员工就可以胜任。

像许多科学或工业进步一样,这种变化将影响许多人:有些人将不得不改变职业或学会在他们的专业中整合GPT;其他人将失去工作。GPT将直接(例如,可以“与机器对话”的提示工程师)或间接地(通过使产品和公司的创建变得更容易)创造新职位。

很难知道确切的影响,但我们正处于一个新阶段的开始,许多事物将发生变化,拥有技术技能的人具有优势,企业家们有一个全新的机会领域。另一方面,许多不愿改变、没有技能或无法负担再教育的人面临威胁。

GPT会摧毁社会吗?

有些人担心AI会导致世界末日:从《黑客帝国》到《终结者》,这在反乌托邦科幻作品中是一个常见的设定。总的来说,有两种情景:

终结者情景:AI被用来赢得战争,被授予军事资源,也许是由一个独裁者掌控,并被赋予了生存本能。人类试图阻止它,AI将其视为威胁,反应激烈。 纸夹优化器:在这个寓言中,AI的任务是尽可能多地制造纸夹。在地球上的资源耗尽后,它转向下一个最可用的碳源:人类。另一个版本是人类试图阻止机器;AI意识到要平静地建造纸夹,就必须摆脱人类。就像邪恶的精灵,通过给你确切地你所要求的,而不是你真正想要的东西来扭曲你的愿望。

需要认识到的一点是(目前)GPT只能产生文本。当然,错误的手中的纯文本可能是危险的(毕竟,独裁者“只是说话”),但就其本身而言,GPT无法做任何事情。然而,它可能是通往更强大系统的第一步:用于控制机器人的GPT衍生产品,军事决策助手等。

我们需要谨慎行事,并在进展变得无法控制或至少未受控制时采取行动。

值得高兴的是,一些AI专家正在积极研究如何防范这些情景,因此可能会有一些安全的前进方式。